通过显卡来给gpt-oss做个加速

之前在我的MacBookPro里使用gpt-oss,因为总的内存只有18g,加上系统本身和各种后台程序的占用,剩下的一般就一半左右,然后这个模型大小就有13g左右,运行起来是很吃力的

正好我这有个服役比较久的windows笔记本,带有3060显卡,只是显存是6g的,想试下看能不能通过显卡来给它加加速,这里我使用了lm studio来运行gpt-oss 20b模型

这个lm studio可以配置有多少层transformer运行在gpu上,

我们可以大致除一下

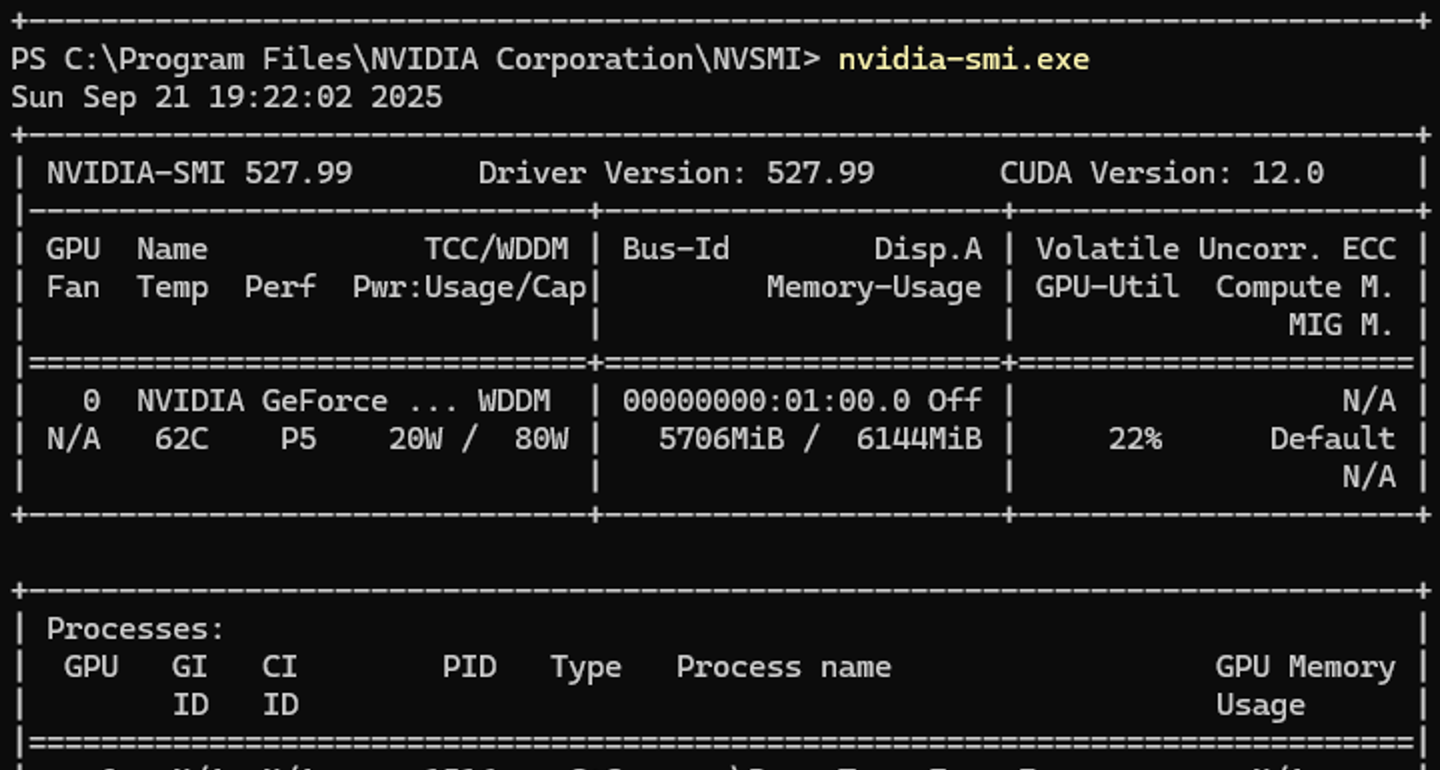

这个gpt-oss 20b是有24层,官标的显存需求是16g,我们有6g显存,大约可以加载8~9层的样子,并且lm studio也自动算出来是加载8层

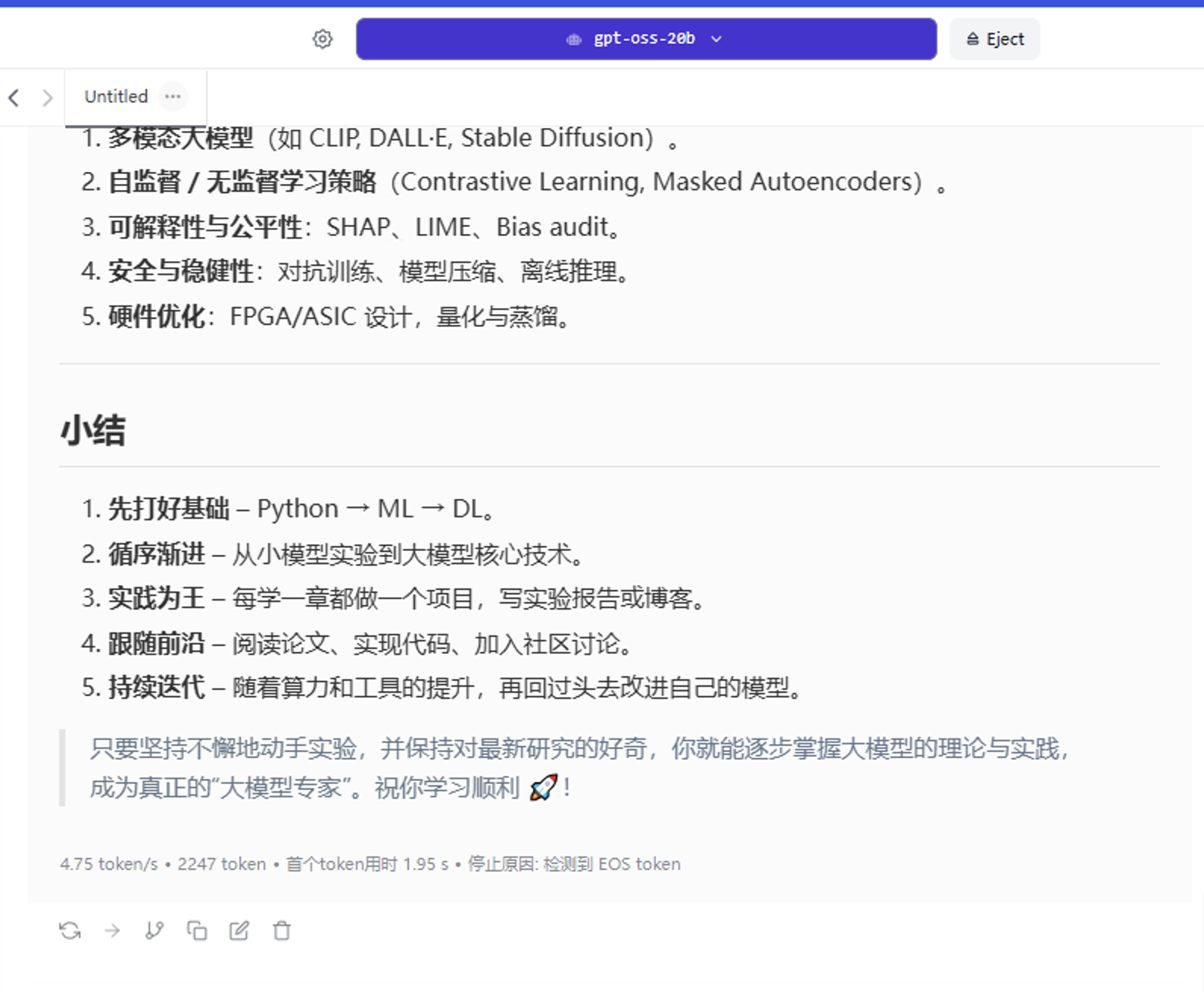

通过这个配置我们运行的gpt-oss能够得到勉强可用的程度

能达到4.x个token的生成速度,还是比mac上要把所有程序全关了,清掉很多token来得方便

实测将gpu卸载层数调整到9是勉强还可以运行,再往上就加载不了了,显存小没办法

当然我们还可以继续用 unsloth 进行微调

例如参考 https://colab.research.google.com/github/unslothai/notebooks/blob/main/nb/gpt-oss-(20B)-Fine-tuning.ipynb

同时可以通过nvidia-smi来查看显存占用

过程中倒是没看到显存完全占满,可以通过nvitop再进行观察

能够在gpu中加载部分层的确能把大模型的生成速度提升一些,但是还是受限于显存大小,最好是能有显存大于16g的显卡可以尝试测一下