git小技巧之git cherry-pick

上次讲了 git stash 跟 git commit 的小技巧,这次来讲下另一个命令,git cherry-pick,我怀疑这个命令应该叫 choose-pick 才比较好

这里有个使用场景,比如我们有分支A跟B,分支B想用一下分支A一次变更的代码,正好不用自己再开发了

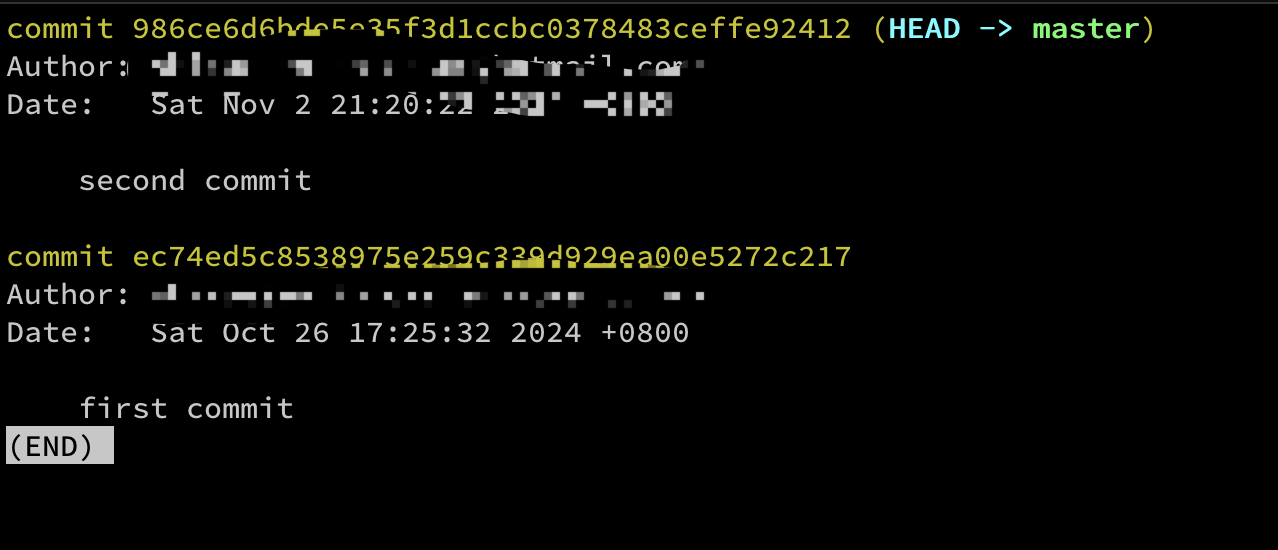

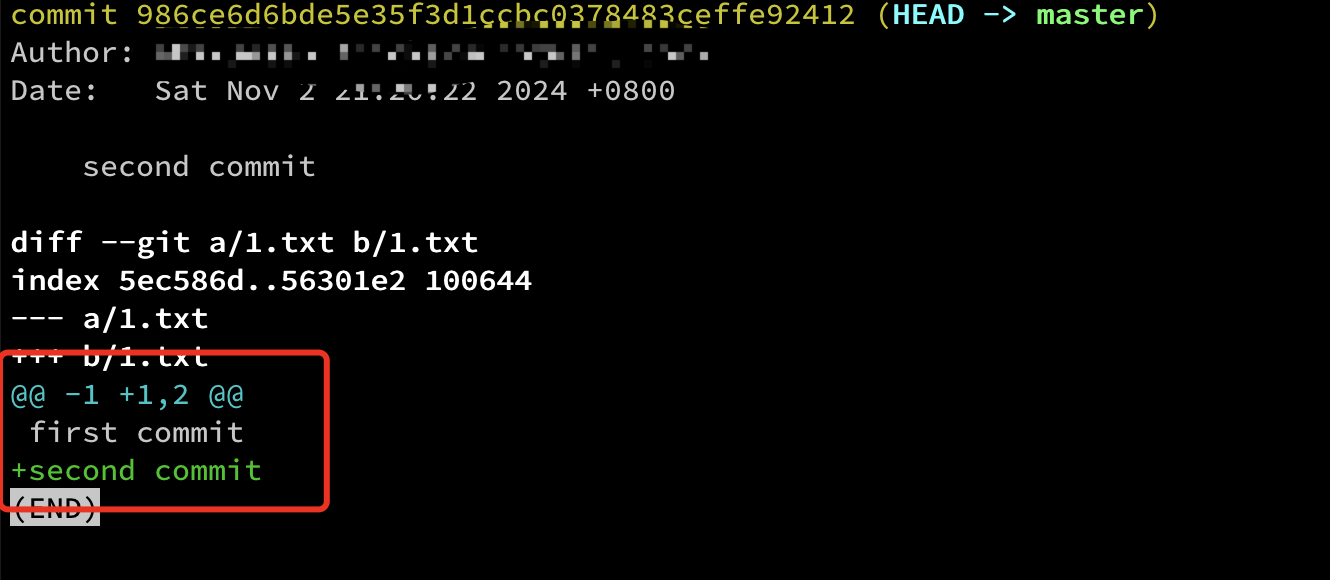

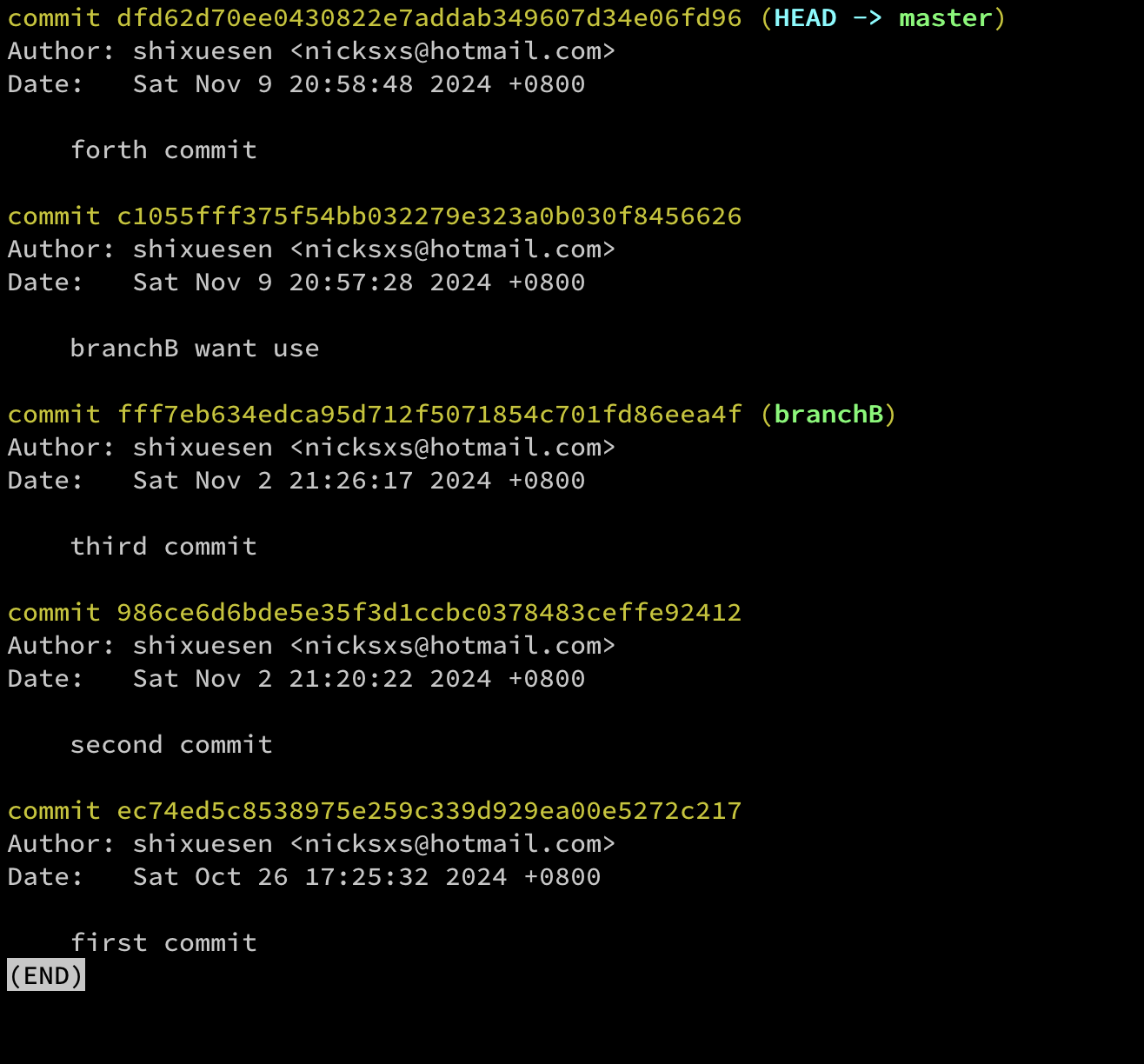

比如我在主分支里提交了一个分支B也想要使用的代码或者内容

然后在后面再提交一次

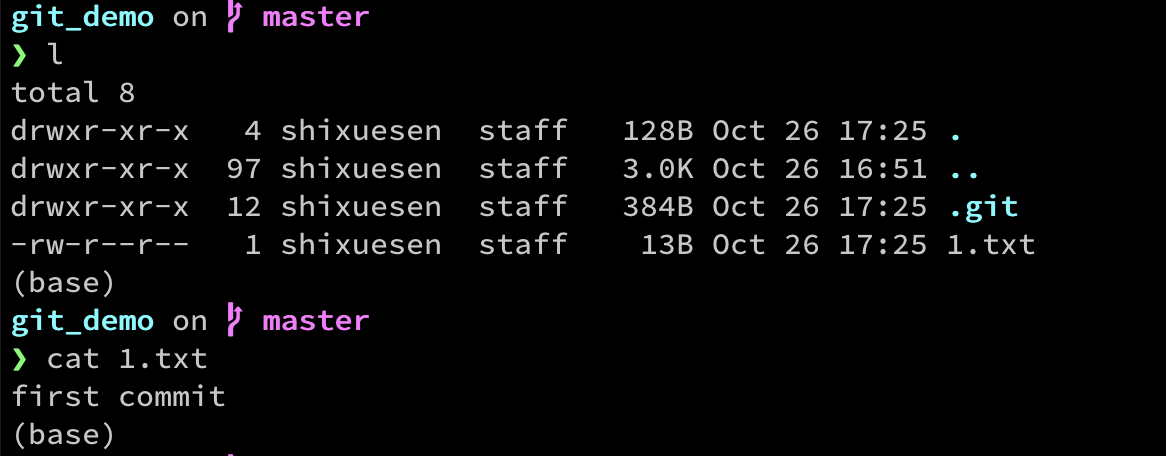

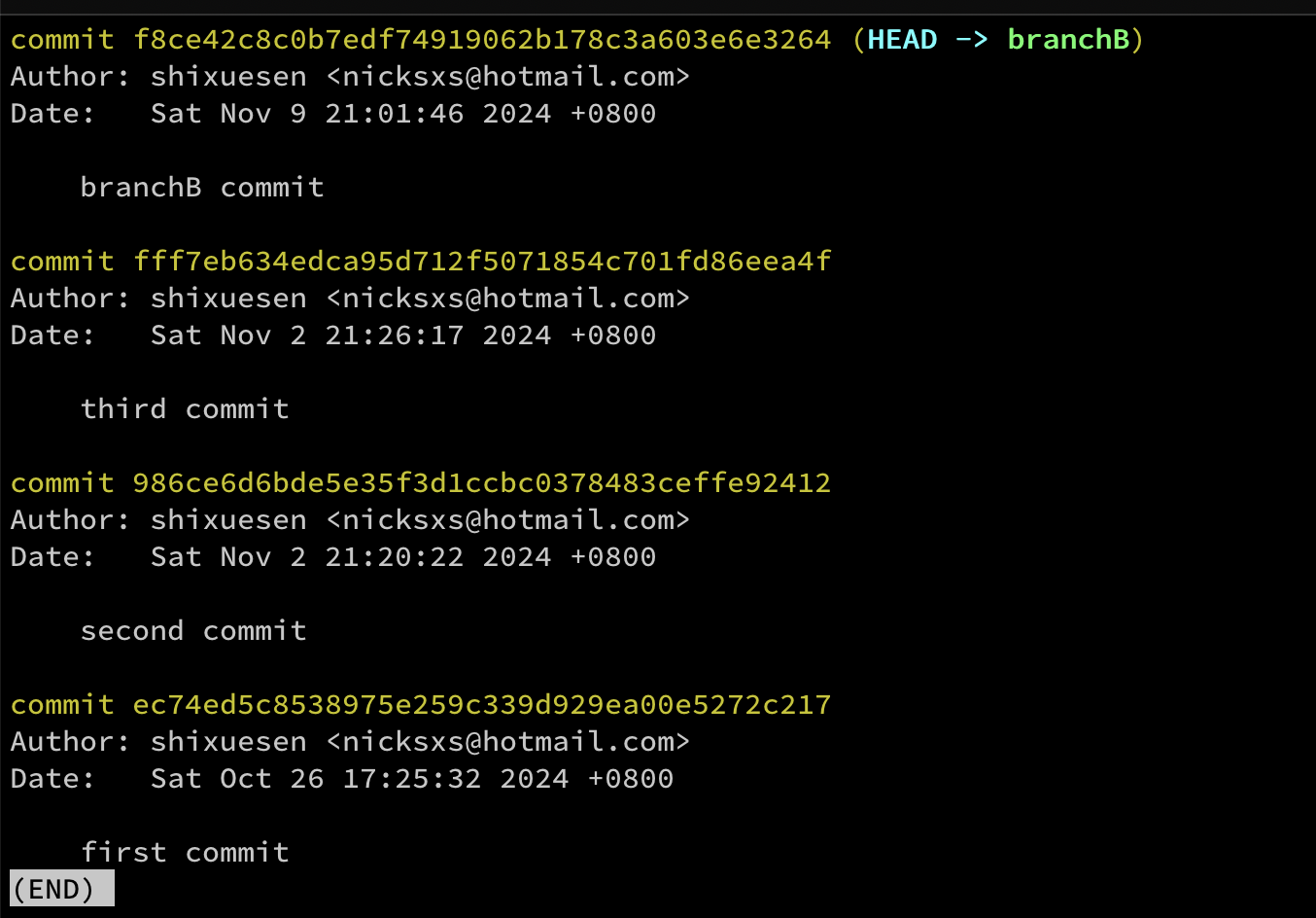

切到branchB,做一次提交

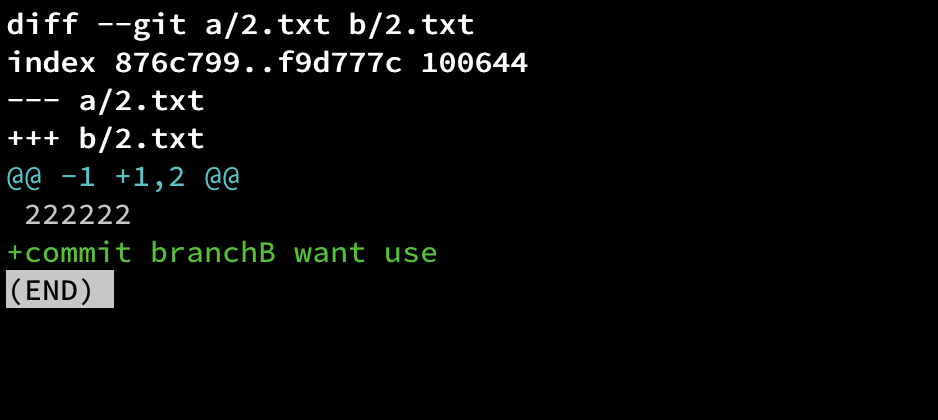

我此时就想把主分支之前那个提交内容给应用到我这个branchB,那就可以用cherry-pick

找到master分支上那个提交 commit id

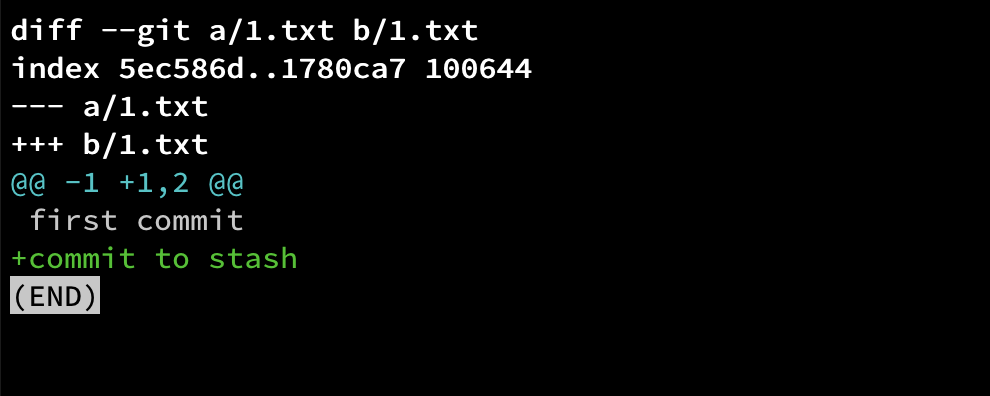

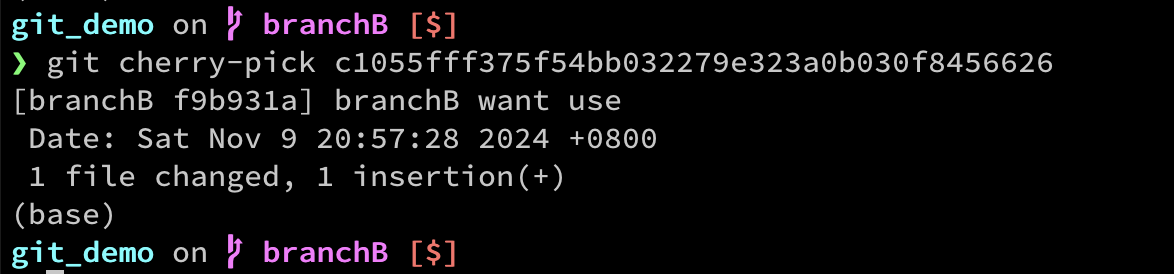

用 git cherry-pick {commit id}

可以看到这个commit已经被我挑过来应用上了

然后再深度使用还有比如是否要产生新提交,还是只在暂存区,以及如果发生冲突了是继续还是停止等等